Comment l'I.A. amplifie les biais systémiques

Introduction à l'intelligence artificielle : Comment l'IA amplifie les biais systémiques

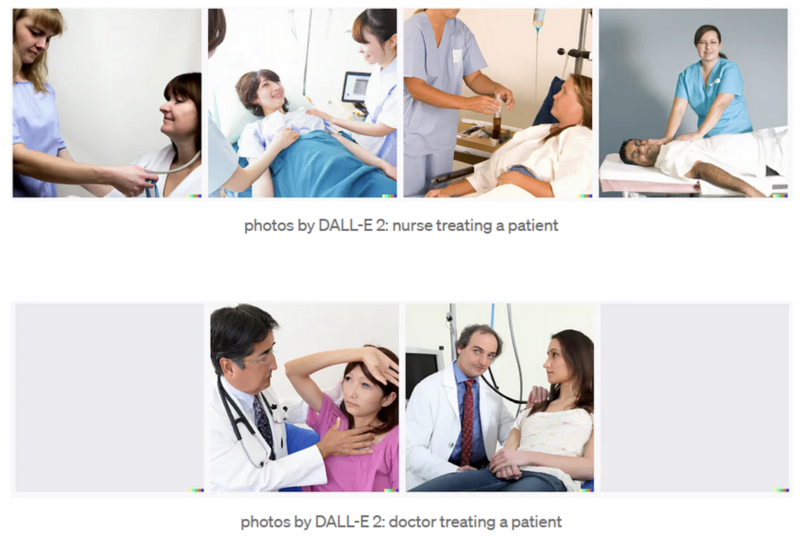

L'IA est inévitable, et ses effets sociétaux sont souvent moins que souhaitables. Au cours des dernières années, nous avons assisté au déploiement d'outils d'IA largement disponibles, y compris de grands modèles de langage comme chatGPT[1], des modèles d'art génératif comme Dall-E[2], et certaines utilisations plus cachées comme la façon dont nous recevons des publicités ciblées. Toutefois, lorsque nous commençons à examiner ces outils, nous remarquons qu'ils ne fonctionnent pas pour tout le monde, qu'ils sont biaisés et qu'ils amplifient les stéréotypes négatifs. Un exemple visuel clair est fourni par le lancement de Dall-E 2, qui génère une image représentative à partir d'une demande d'entrée[3]. Lorsqu'on lui demande de montrer des images de différentes professions, des stéréotypes sexistes de longue date apparaissent : les infirmières sont des femmes, les médecins sont des hommes et tout le monde est blanc.

L'IA, l'apprentissage automatique en particulier, est capable de reconnaître des modèles. Ce qui signifie que lorsqu'elle est appliquée à une société qui présente des schémas d'oppression, elle apprend à opprimer. Les biais des modèles d'IA ont conduit à des arrestations injustifiées, à la perte de bourses d'études, à des refus de prêts, à des accusations de tricherie injustifiées, à des diagnostics erronés... Et ils affectent toujours de manière disproportionnée les personnes BIPOC, les personnes Queer, les femmes et les personnes handicapées. [4][5]

En tant que boursier en IA, je me suis concentré sur la manière dont nous pouvons fournir un vocabulaire technique et une compréhension aux étudiants en dehors de la discipline informatique, de manière à placer l'humanité au premier plan. L'objectif est de permettre aux étudiants de reconnaître les abus potentiels de l'IA, de remettre en question le technochauvinisme - la croyance que la technologie est toujours la solution [6] - et de comprendre comment se protéger dans le monde de l'après-IA. Actuel

Les cours facultatifs d'informatique sont structurés sous forme de cours magistraux et de travaux pratiques en binôme. Chaque période de cours devrait se concentrer sur un sujet spécifique de l'IA/ML (c'est-à-dire la prévision, la traduction, la modélisation du langage, la reconnaissance faciale,...), en définissant d'abord la tâche et en explorant comment l'intelligence humaine pourrait la résoudre, puis en démontrant comment l'IA la résout, et enfin en explorant comment l'IA est mise en œuvre. Discuter de la manière dont les humains résolvent des tâches complexes vise à la fois à rappeler que l'IA n'est pas la seule solution et à critiquer les éléments de l'intelligence humaine qui ne sont pas transposables à l'IA (ou les éléments de l'IA qui améliorent l'intelligence humaine). Cela conduit à discuter de la manière dont la technique spécifique peut être utilisée pour le bien, et à l'inverse de la manière dont elle peut causer du tort. Les périodes de laboratoire peuvent ensuite être utilisées pour construire nos propres versions des modèles discutés, en suivant des exercices fortement guidés, et en explorant les pièges et les dangers qui peuvent survenir. Par exemple, lors de la conception d'un modèle de prévision, il est possible d'inclure des variables qui sont des substituts de la race, du sexe, de l'orientation sexuelle, de la religion,... et ensuite de faire des prédictions à partir de ces variables. Google Colab dispose d'un didacticiel sur l'IA équitable, qui peut servir de point de départ[7].

Cela peut être utilisé pour discuter de manière critique des sujets en classe, puis pour mettre en évidence les pièges et les dangers potentiels dans les périodes de laboratoire à l'aide d'exercices fortement guidés. L'objectif que je propose n'est pas d'enseigner aux étudiants comment écrire du code d'IA, mais d'utiliser du code pré-écrit comme moyen de démonstration et d'exploration, et de construire des parcours de communication sur l'IA, de travail avec l'IA, et de reconnaissance des sources potentielles de déséquilibre systémique.

Le dossier comprend une proposition de plan pour ce type de cours, un exemple de cours et de laboratoire pour la partie reconnaissance faciale (avec feuille de travail et code) ainsi qu'un cours d'introduction à l'IA et à la ML, qui a été adapté à partir de mes travaux antérieurs et n'est pas un produit fini.

Plan du cours

Schéma de Bodzay 420-BWC-AI-Draft

Série Reconnaissance faciale

Conférence :

Feuille de travail :

Laboratoire :

L'abécédaire des ML :

Bodzay Dawson AI - Introduction au ML

Références et ressources

- https://openai.com/blog/chatgpt

- https://openai.com/dall-e-2

- https://medium.com/mlearning-ai/dall-e-2-creativity-is-still-biased-3a41b3485db9

- Broussard, M. (2023). More than a Glitch : Confronting Race, Gender, and Ability Bias in Tech. The MIT Press.

- Benjamin, R. (2020). La race après la technologie : Outils abolitionnistes pour le nouveau code JIM. Polity.

- Broussard, M. (2019). L'inintelligence artificielle : Comment les ordinateurs comprennent mal le monde. The MIT Press.

- https://colab.research.google.com/github/google/eng-edu/blob/main/ml/cc/exercises/intro_to_ml_fairness.ipynb